2015-09-10 수업 필기내용

- 과정명 : System Center Technical Training

- 일 정 : 2015년 9월 10일(목) ~ 11일(금)

- 시 간 : 09:30 ~ 18:00 (7.5H)

- 장 소 : 러닝웨이코리아 강남센터 3강의장

- 강 사 : Microsoft 우진환 차장님

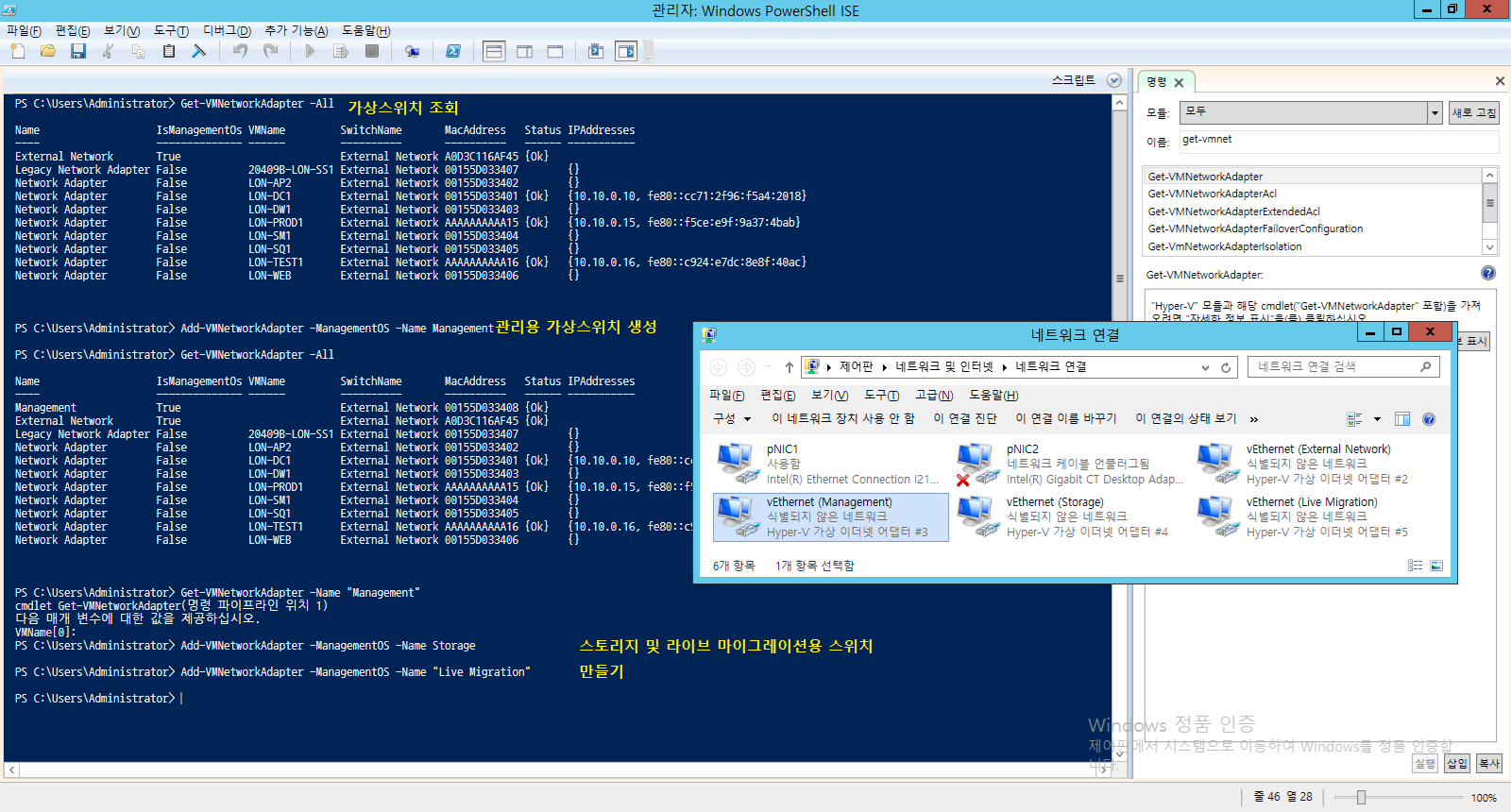

Virtual Switch vs Virtual Network Adapter

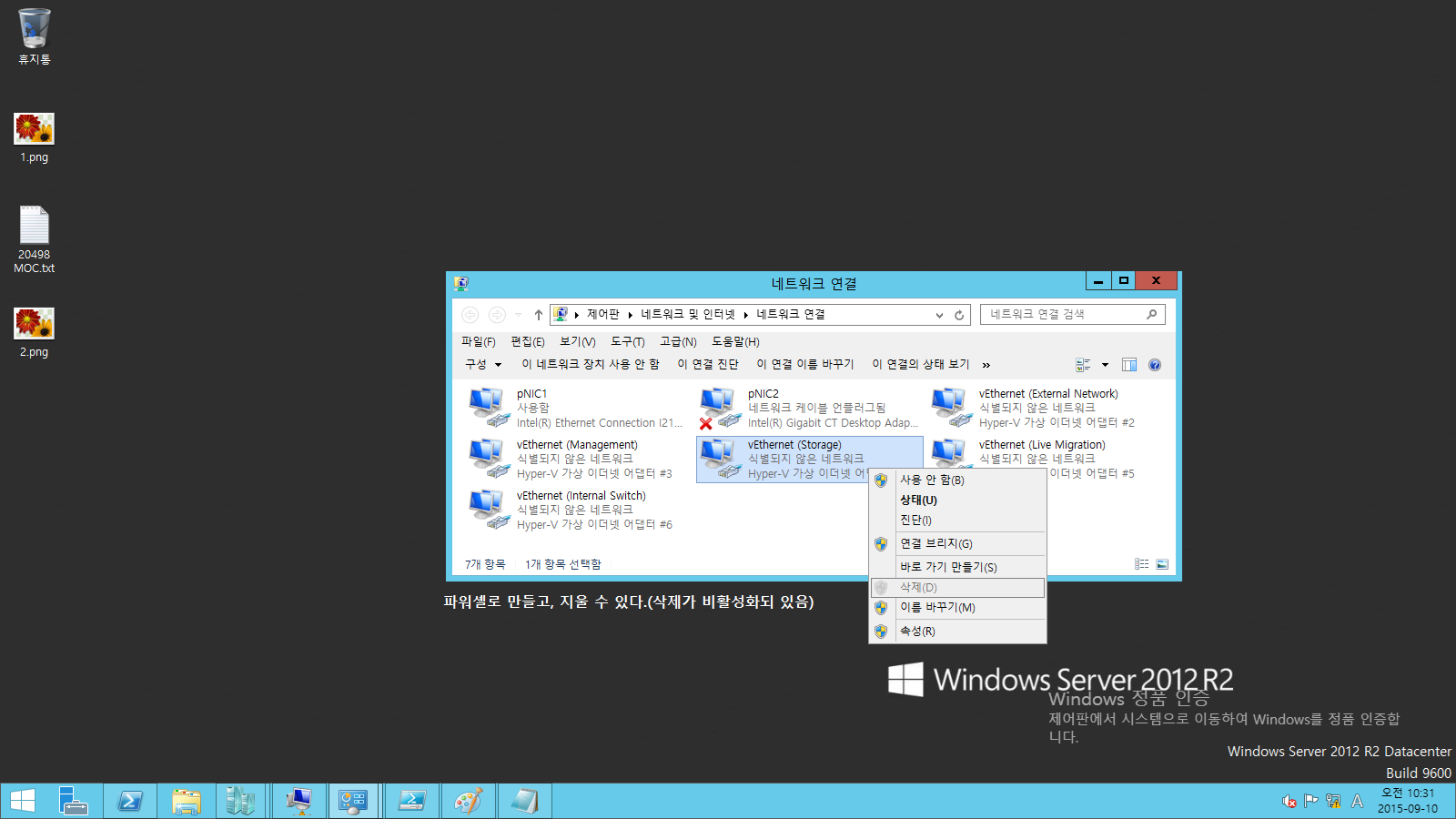

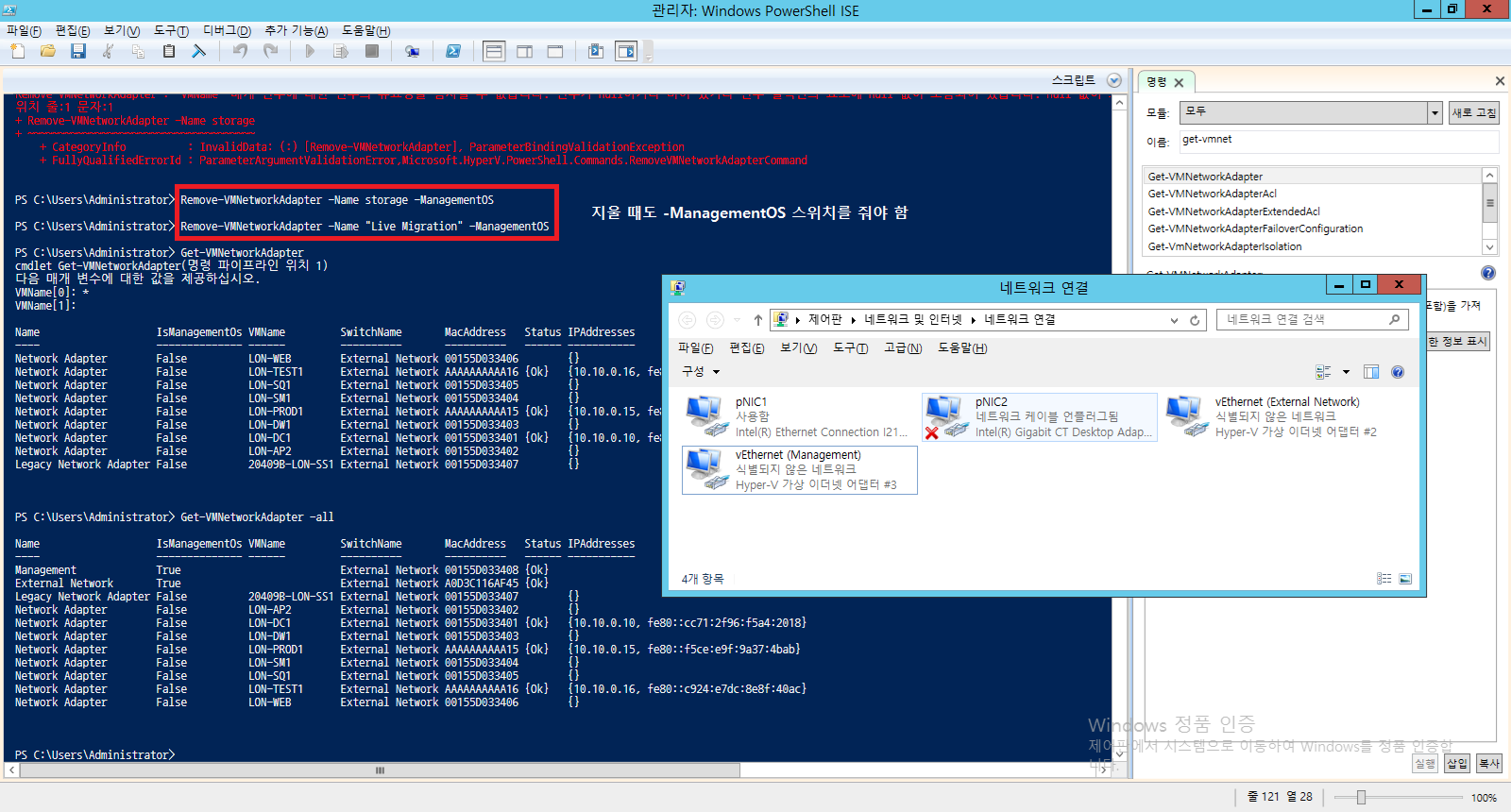

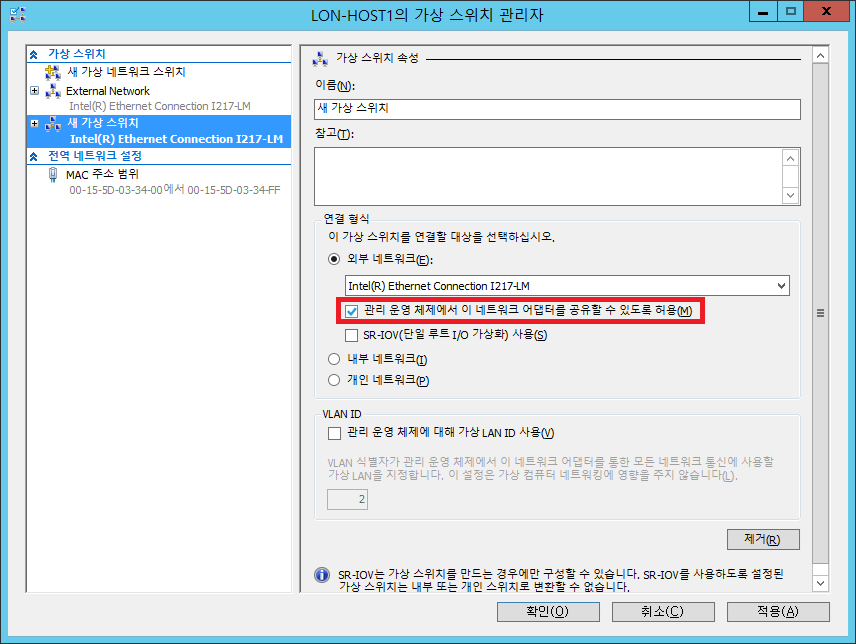

‘새 가상 스위치’를 만들면 Hyper-V 호스트 안에 Switch(마치 공유기와 같은)가 만들어짐. VM 종료된 상태에서 VMNetworkAdapter를 만들 수 있음. Hyper-V 호스트에 가상 네트워크 어댑터를 만들 수 있는 UI가 없음. 유일하게 아래와 같이 체크하는 순간 External Adapater와 똑같이 생긴 어댑터가 만들어지는 것.

어댑터 모두 쿼리

스위치 모두 쿼리

- VMSwitch: 가상 허브가 아니라 스위치이기 때문에 포워딩, 캡처, 제한, 네트워크 침입 감지 등을 VMVirtualSwitch에 추가할 수 있다.

- ACL is Access Control List 접근 제어 리스트

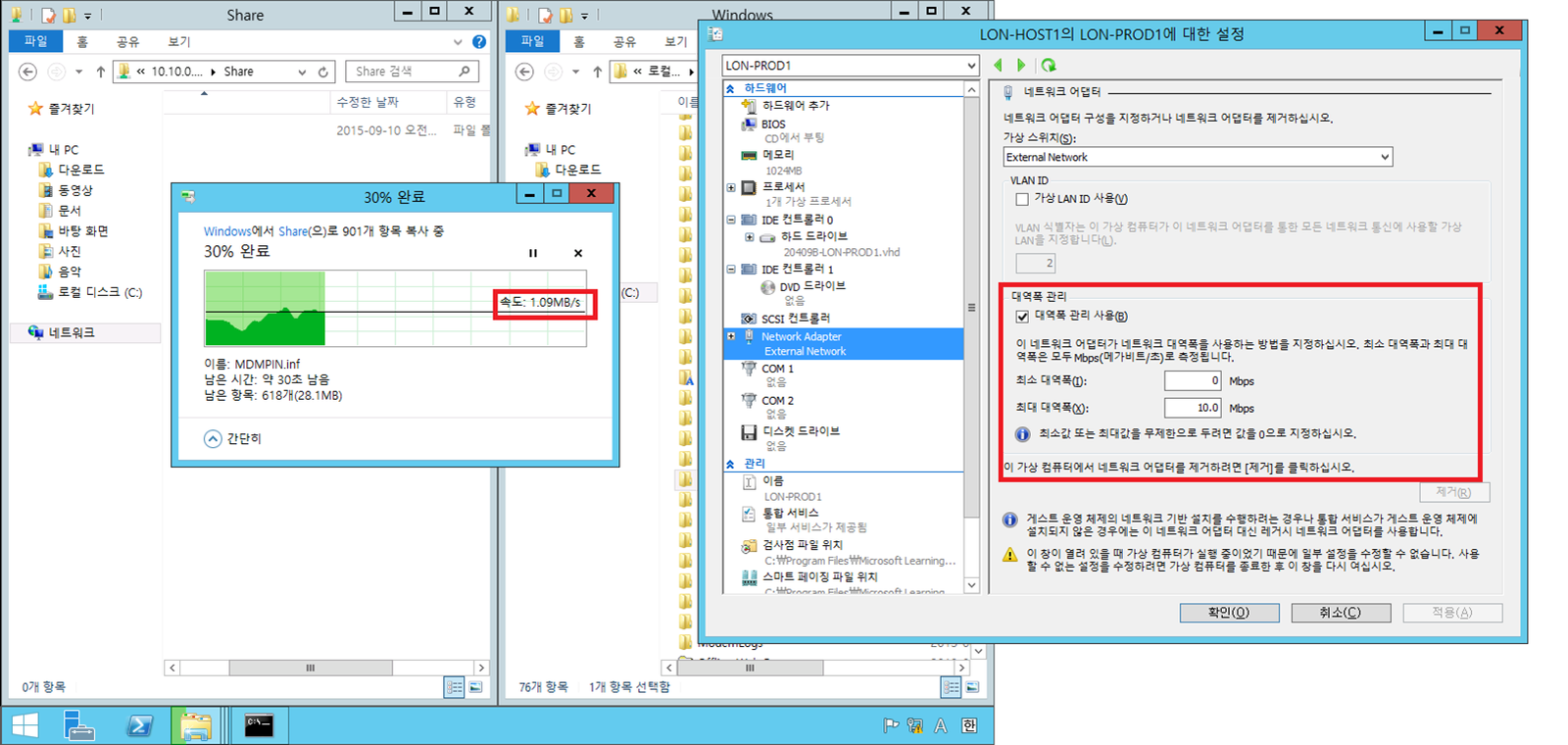

- Legacy Network에는 트래픽 제한을 걸 수 없음

- SR-IOV 어댑터는 Live Migration용으로 많이 씀(필터가 적용되지 않고 바로 지나감)

Teaming: 가상 머신 안에서도 티밍이 지원됨

티밍 어떻게 선택할 것인가?? R2에서 대역폭도 올리고 Fail-over도 지원하는 기본값이 생김

네트워크 가상화

고립(isolation), 추상화(abstraction)

- 고립: 가상화에서 고립이 중요해짐 : Parent Partition에서 Child Partition과 고립된 이야기, 아키텍처상 VM끼리 고립되어 있음

- 추상화: 추상화 레이어에 들어가면 위쪽에 떠 있는 레이어를 다른쪽으로 가져가서 쓸 수 있음

Docker도 기본적인 컨셉은 동일.

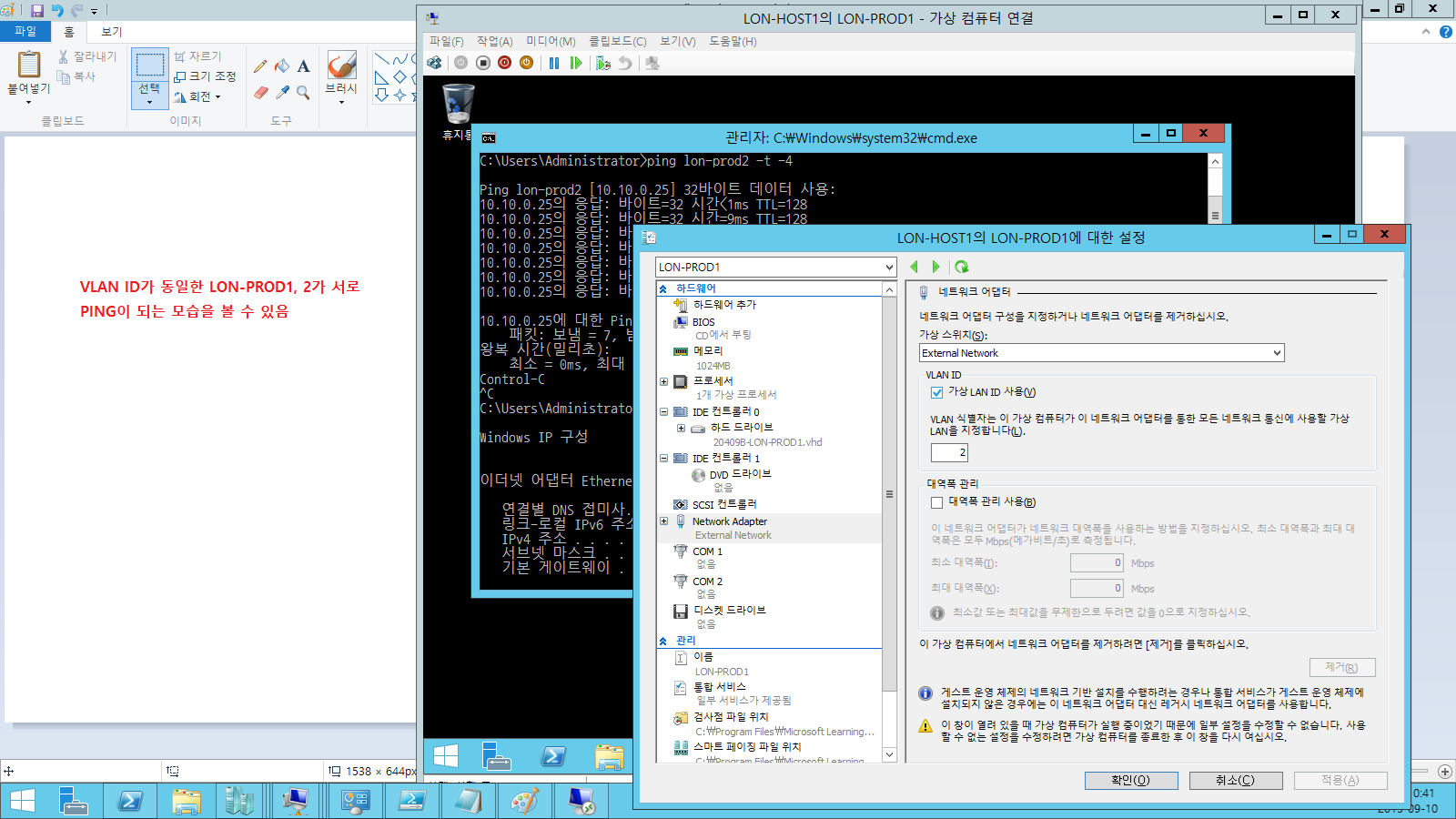

- 네트워크 고립: VLAN(4000여개 정도 밖에 지원 안 함)으로 할 수 있는 고립의 한계 -> Datacenter 수준에서 너무 부족(그만큼 적은 고객사밖에 서비스하지 못함) -> NV-GRE를 사용하여 VLAN의 한계를 극복 (그리고 VLAN에 대한 마킹을 각 스위치와 VM마다 해줘야 하는 한계가 있음. 스위치가 교체, 추가된다면??? -_- VLAN보다 나은 네트워크 고립을 사용해줘야 하는 필요성 생김)

- 네트워크 추상화: 거대한 네트워크 구조를 그대로 다른 곳에 복제하거나 이동할 수 있는 가능성이 필요해짐(마치 Datacenter에서 재해복구 등에 활용하는)

- Network Virtualization의 표준화: OS벤더, Network장비 벤더에서 서로 추진 중… MS에서 미는 기술은 NV_GRE(Generic Routing Encapsulation)

Satya Nadella CEO: “모든 것을 다 받아 주어라”

하드웨어 스위치도 SCVMM에서 컨트롤할 수 있음 -> 진정한 네트워크 가상화 구현

**네트워크 가상화에서 물리 네트웍과 네트워크 트래픽 사이의 추상화 제공

네트워크 가상화 이점

- 유연한 가상 머신 배치

- VLAN 없이 멀티테넌트 네트워크 고립

- IP 주소 재사용

- 서브넷 간 실시간 마이그레이션

- 기존 네트워크 인프라와 호환

- 공유된 IaaS 클라우드로 가상 머신의 투명한 이동

NVGRE

VLAN: IP Packet에 VLAN ID 값을 추가해서 보내는 것. NVGRE도 동일함

(호스트)192.168.2.22 -> 192.168.5.5 | GRE Key=5001 | MAC | 10.1.1.11 -> 10.1.1.12(VM)

(호스트)192.168.2.22 -> 192.168.5.5 | GRE Key=6001 | MAC | 10.1.1.11 -> 10.1.1.12(VM)

GRE Key가 같은 것끼리 네트워크

VM이 어떤 Hyper-V 호스트에 있는가?? 를 알아야 서로 주고 받고(Migration) 할 수 있음 -> 이것이 NVGRE 정책임

파란 네트워크에 있는 애들이랑 빨간 네트워크에 있는 애들이랑 고립을 시켜줌

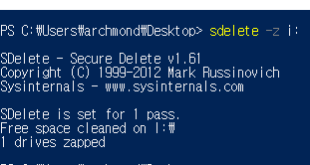

실습

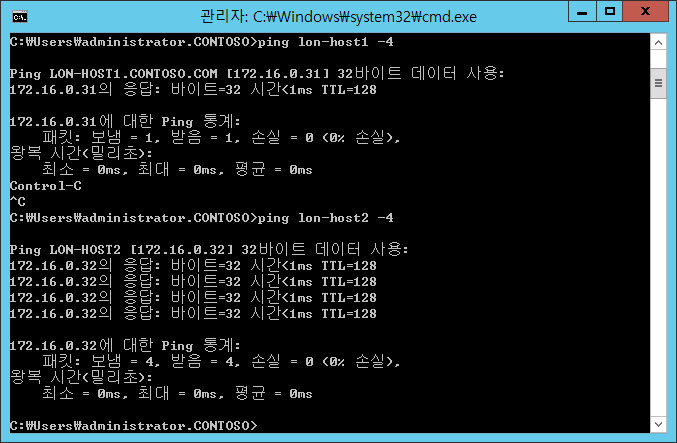

모두 PING이 되는 상태.

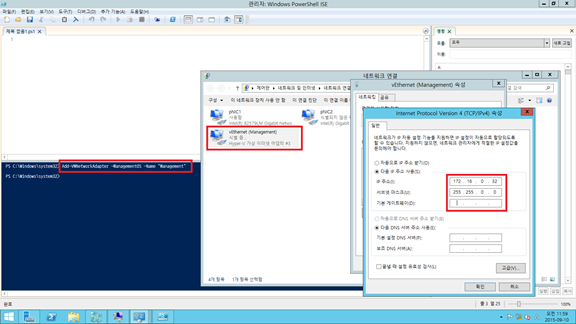

호스트 컴퓨터의 Management 어댑터에 설정.

HOST2에서도 설정

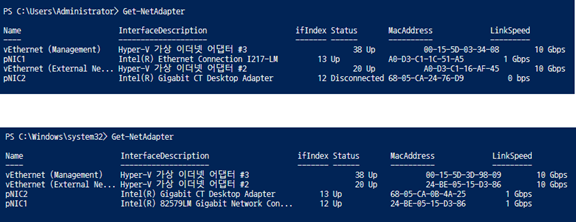

호스트1, 2의 pNIC의 Interface Index 번호를 기록해놓는다.

변수 선언.

룩업레코드 추가

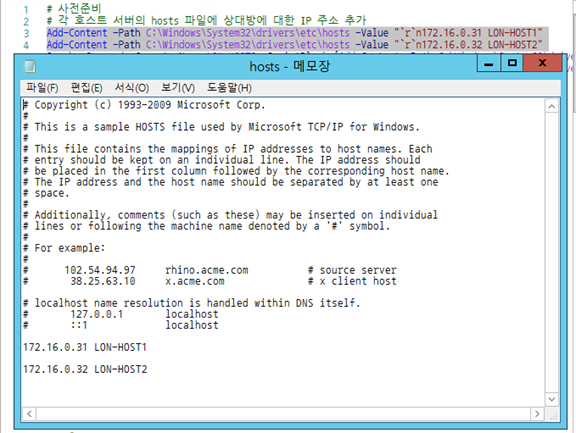

hosts 파일에 추가해주는 스크립트

두 호스트의 hosts 파일에 내용이 들어가서 hostname으로 IP 조회 가능

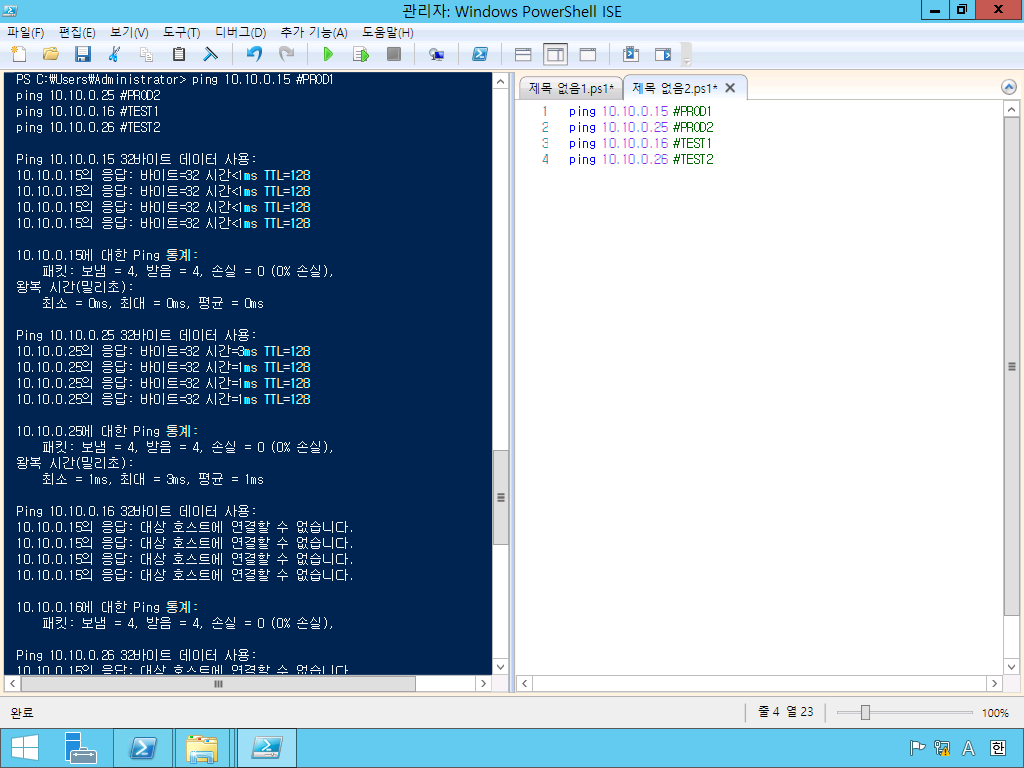

PROD는 PROD끼리, TEST는 TEST끼리만 네트워크되는 것을 확인 가능.(VLAN 없이!) 하지만 VM이나 호스트가 늘어날수록 스크립트가 복잡해지고 양이 많아질 것임. -> System Center를 도입해야 하는 이유…

Hyper-V & Server 2012 R2

I/O 중복

Storage MPIO와 Multichannel SMB는 기본적으로 같은 기능을 함(대역폭 증가 효과)

Live Migration

Live Migration은 TCP time-out 간격보다 적은 시간 내에 완료됨(라이브 마이그레이션용 네트워크 품질이 중요하다)

실습

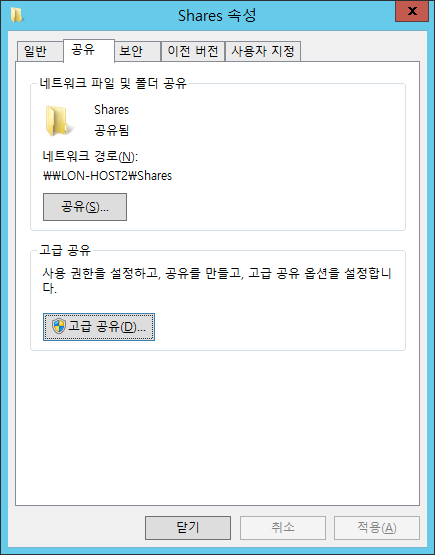

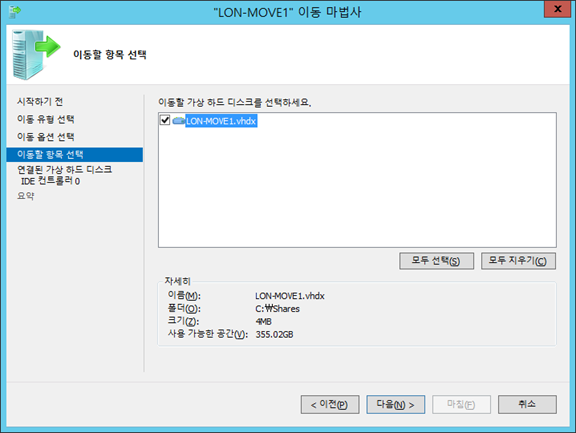

공유폴더 만들고 스크립트를 실행해 VM을 만들고 실행됨

New-VM –Name LON-MOVE1 –MemoryStartupBytes 512MB –Generation 1 –BootDevice IDE

New-VHD C:\Shares\LON-MOVE1.vhdx -Dynamic -SizeBytes 100GB

Checkpoint-VM -Name LON-MOVE1

Add-VMHardDiskDrive –VMName LON-MOVE1 –ControllerType IDE –Path C:\Shares\LON-MOVE1.vhdx

Start-VM LON-MOVE1

New-VM –Name LON-MOVE2 –MemoryStartupBytes 512MB –Generation 1 –BootDevice IDE

New-VHD C:\Shares\LON-MOVE2.vhdx -Dynamic -SizeBytes 100GB

Checkpoint-VM -Name LON-MOVE2

Add-VMHardDiskDrive –VMName LON-MOVE2 –ControllerType IDE –Path C:\Shares\LON-MOVE2.vhdx

Start-VM LON-MOVE2

용량이 얼마 안 되어 금방 끝남.

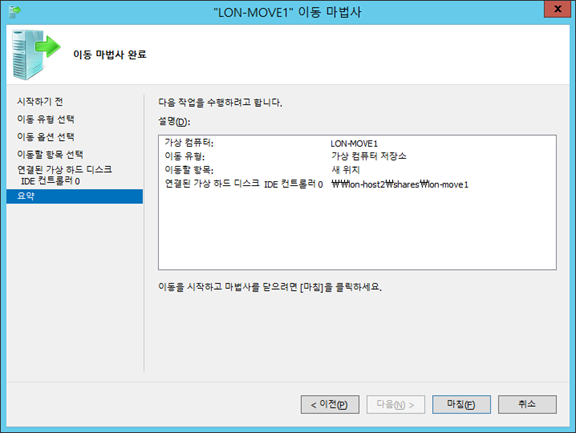

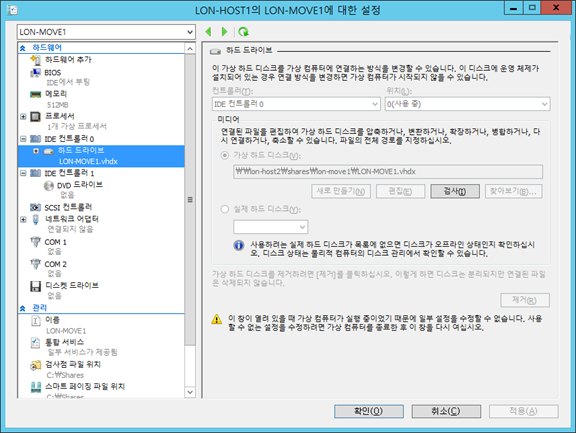

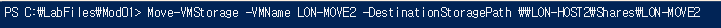

제대로 옮겨졌다.^^(UNC경로… 2012 R2라서 SMB 3.0 이라 된다는…)

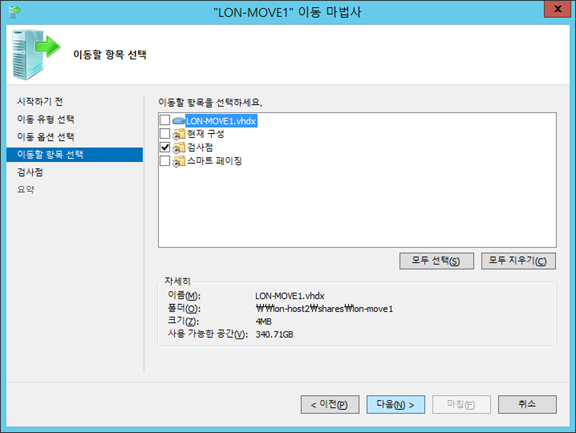

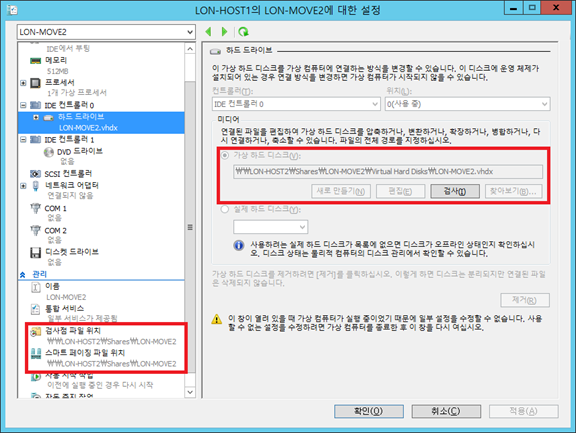

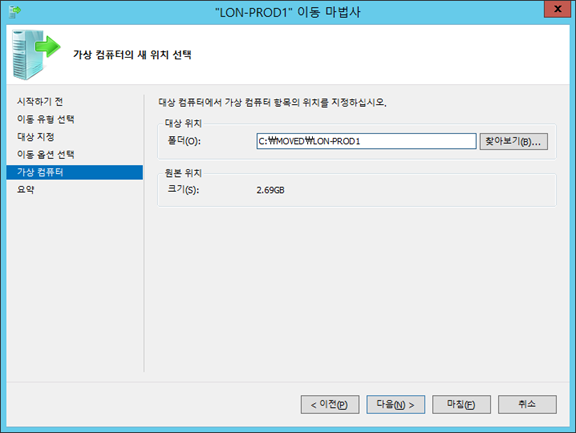

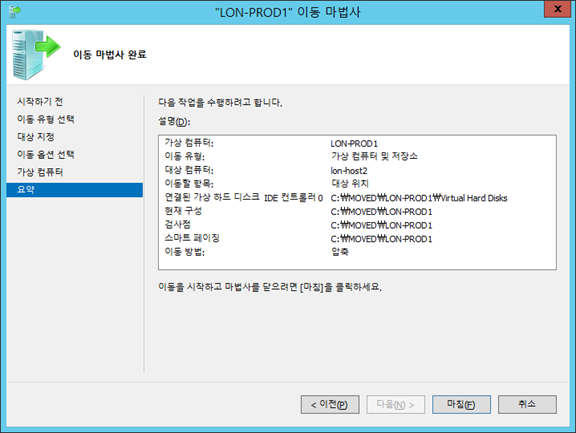

하지만 검사점 등은 C:\에 있는데… VHD가 있는 스토리지는 일반적으로 좋은 디스크를 쓰니, 검사점이나 페이징 등은 다른 드라이브로 설정할 수 있다는 것을 보여주는 스크린샷.

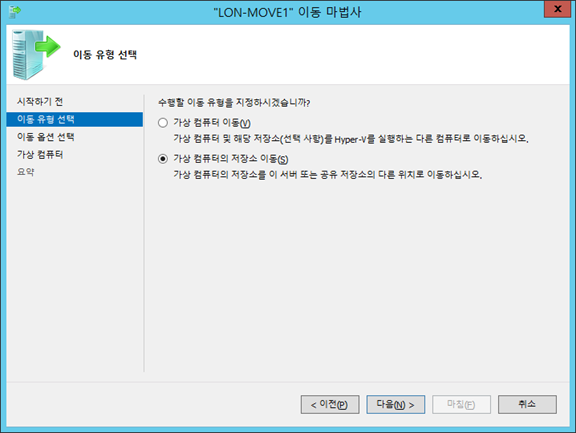

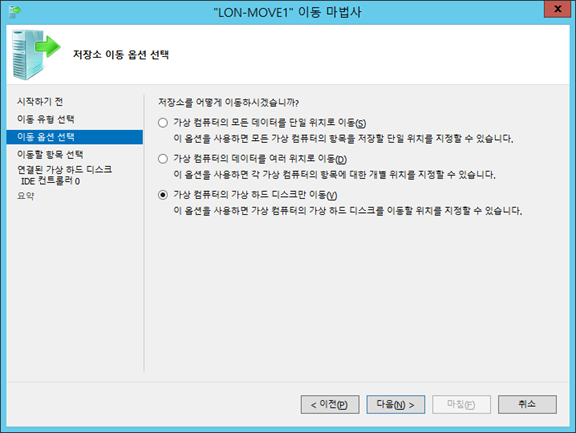

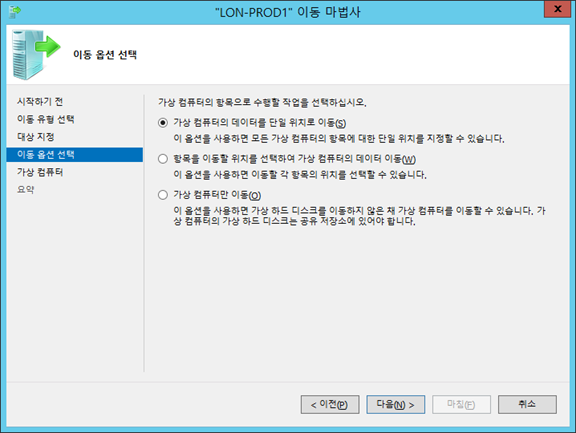

여러 위치로 이동

체크포인트만 다른 곳으로 이동 가능!!

체크포인트 파일 위치가 저가의 스토리지로 이동됨.

모든 저장소 관련 파일을 옮겨줌.

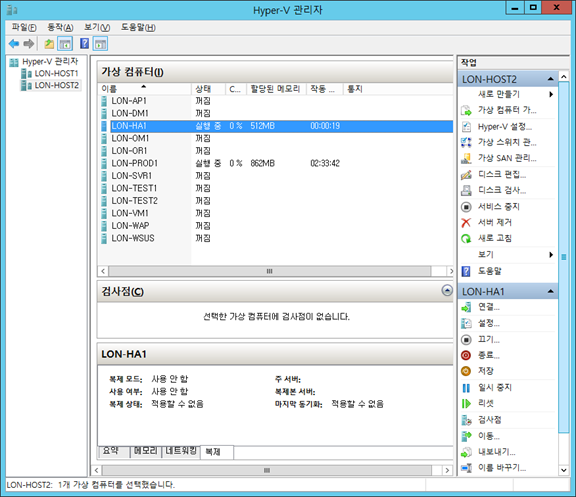

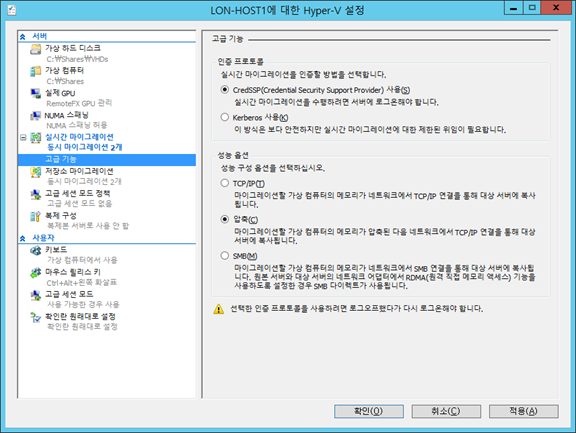

실시간 마이그레이션

Hyper-V 설정에서 체크

고급에 가보면 성능 옵션이 있음. SMB 옵션을 선택하면 SMB File Server에서 RDMA(또는 SMB Direct라고도 함)을 지원하는 NIC에 의해 아주 빠른 속도로 작업이 끝남. 인증 프로토콜에서 Domain 환경이면 Kerberos를 사용할 수 있다. Azure는 당연히 CredSSP 사용.

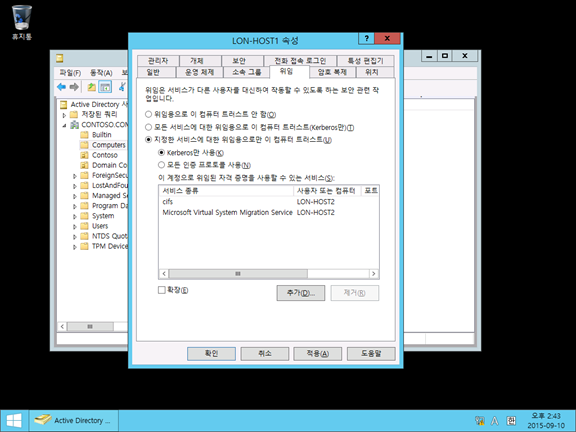

위임 설정

호스트1에서는 2에 대해 Kerberos Purge를 해줘야 함(잘 안 될 때…)

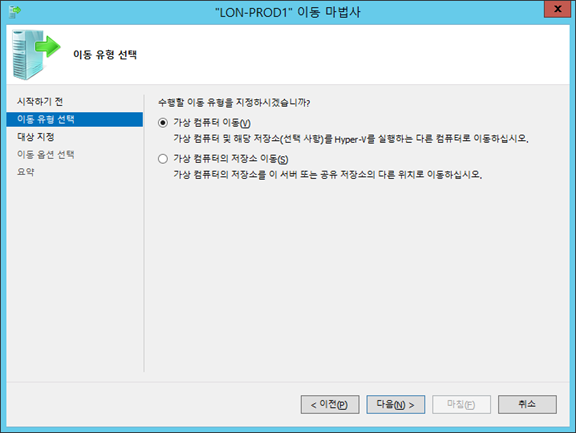

이동!

통지 쪽을 보면 얼마정도 이동되었는지 확인 가능.

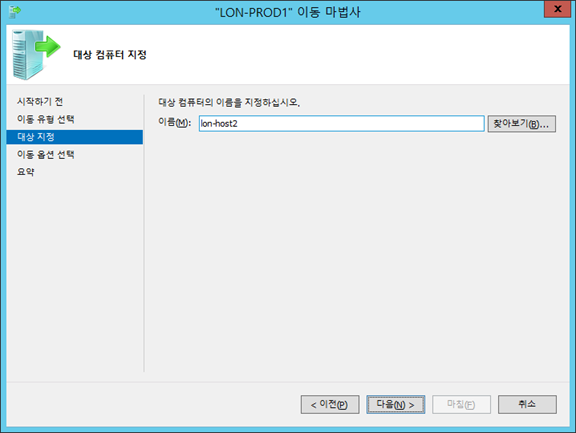

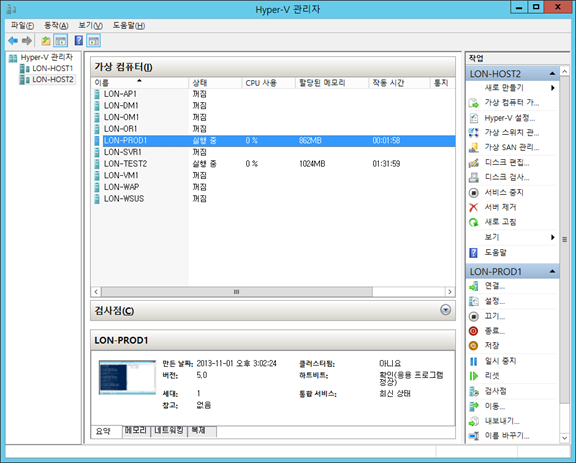

이번에는 호스트2 에서 호스트1로 이동…

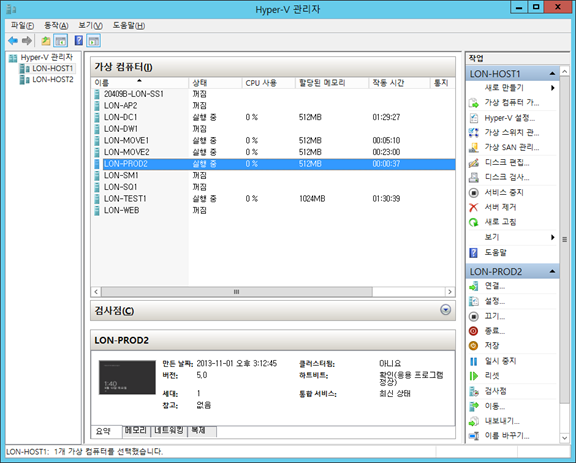

PROD1 -> 이동 완료!

PROD2 -> 이동 완료!

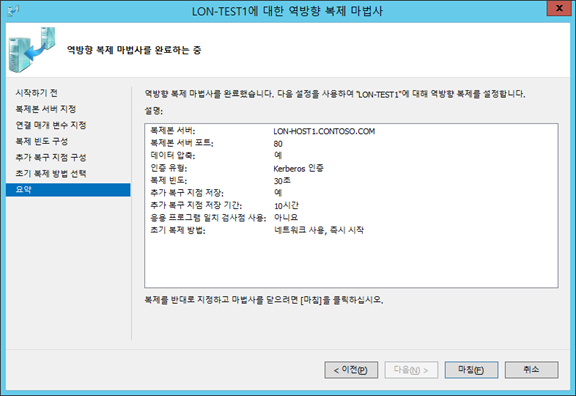

Hyper-V Replication

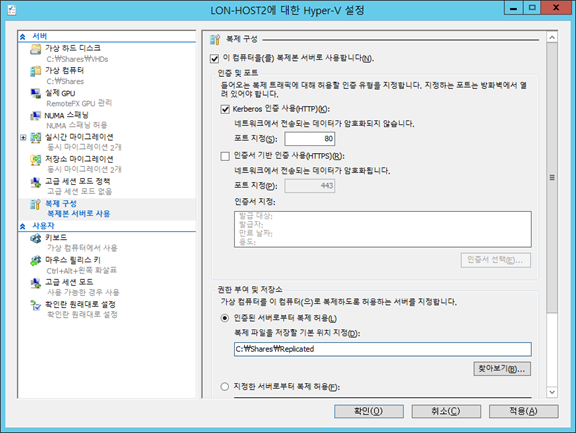

호스트2에서 설정

방화벽을 열어라고 알려줌.

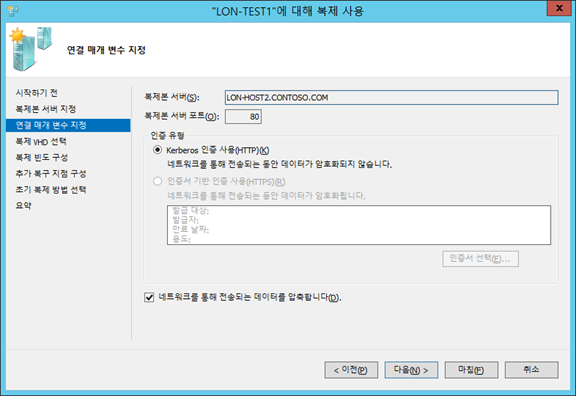

LON-HOST2의 Hyper-V 복제본 수신기를 HTTP, HTTPS 모두 켜줌. LON-HOST1에서도 동일하게 설정, wf.msc 에서 인바운드 동일하게 설정

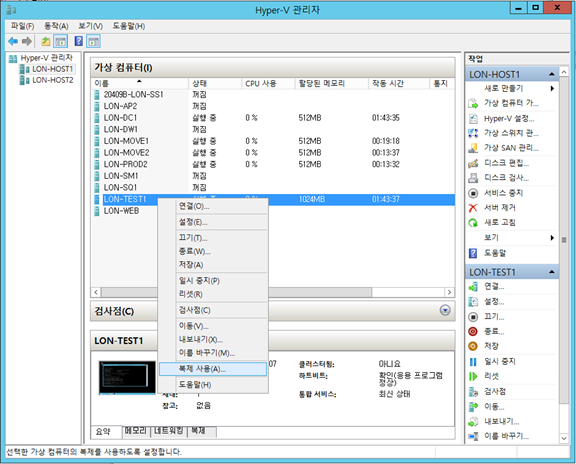

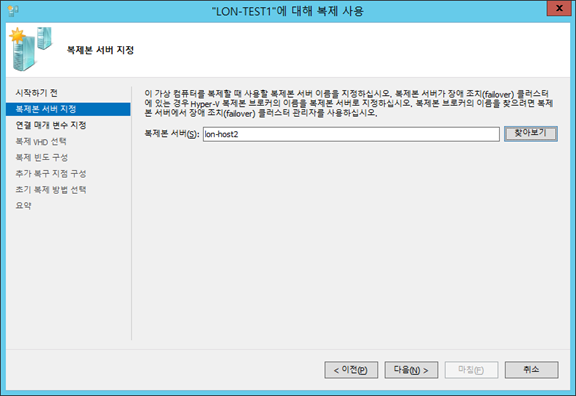

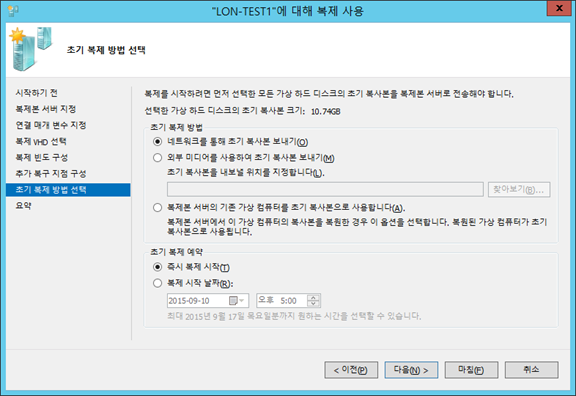

복제 사용 선택

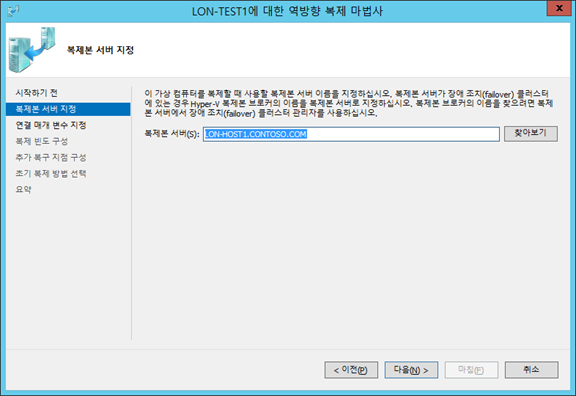

복제본 서버를 LON-HOST2

압축이 기본 옵션임.

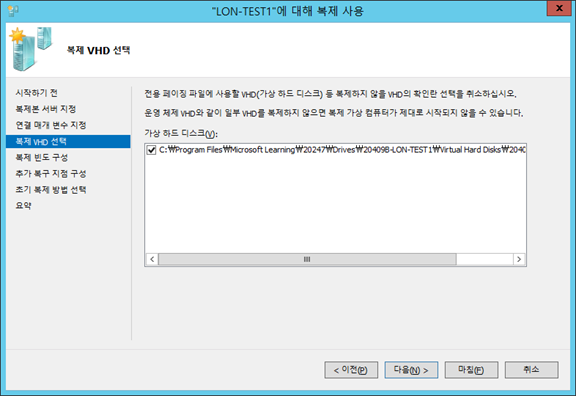

(운영체제를 제외하고 데이터 디스크만 복제하는 것도 가능!)

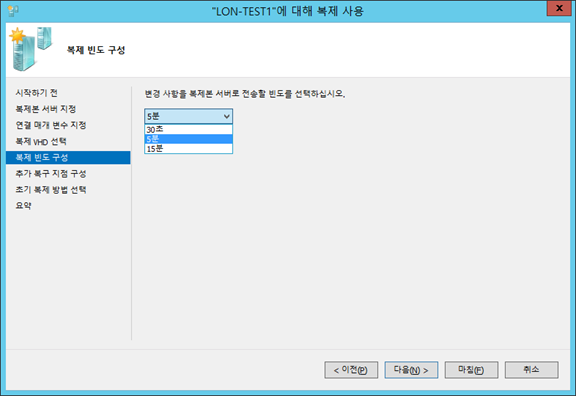

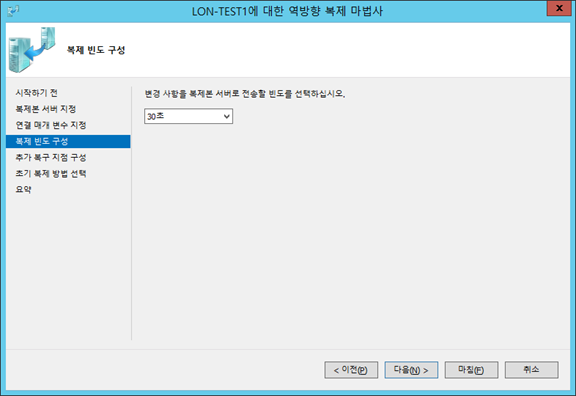

2012에서는 선택이 안되던 화면. 과감히 30초 선택.

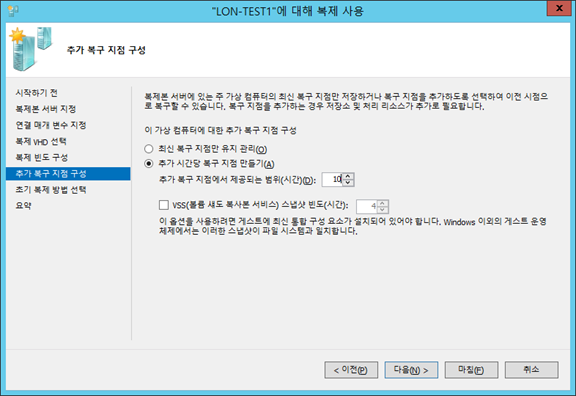

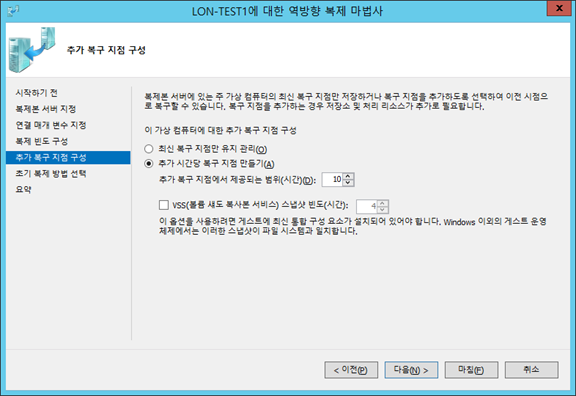

원본 서버에서 Replication 서버로 복제 시 ’10시간마다 한 번씩 스냅샷을 찍겠다’는 이야기. 원본 서버의 VM에 문제가 생겼을 때 Replication의 복제된 내용이 예전 스냅샷을 갖고 있게 됨.

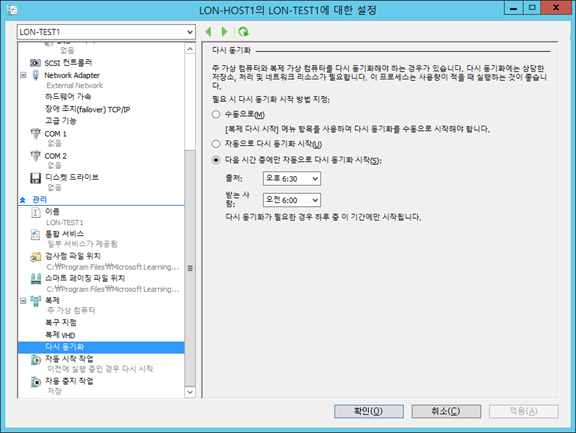

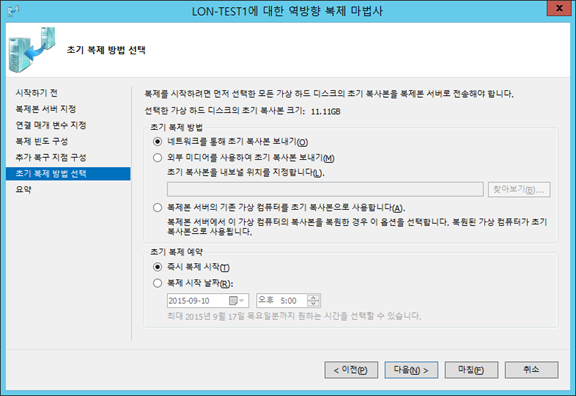

복제를 업무 시간에 하지 않으려면 시간 선택 가능.

복제 시작~

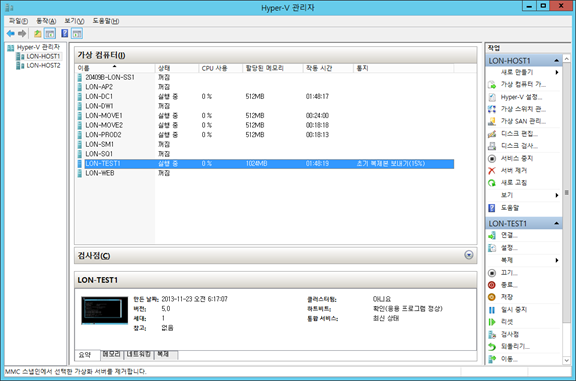

1에서는 2로 보내고 있고,

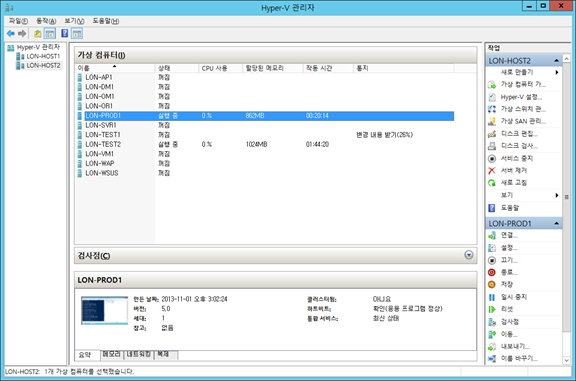

2번에서는 변경 내용 받기 진행 중..ㅎ

복제 -> 복제 상태 보기

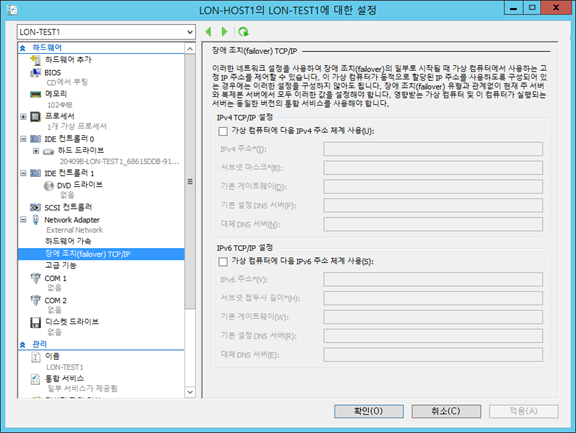

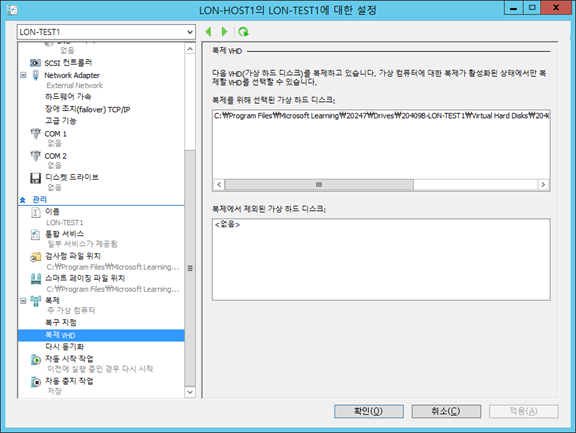

LON-TEST1의 설정에 들어가면 장애 조치 TCP/IP 항목이 생김. (원본 서버가 서울이라 10.x 대 IP이고 부산에 복제되는데 그곳은 20.x 대 IP인 경우를 대비)

하단에 복제 메뉴가 생김

흥미로운 설정들이 들어 있음

다시 동기화 시점

하단의 복제 탭이 생김.

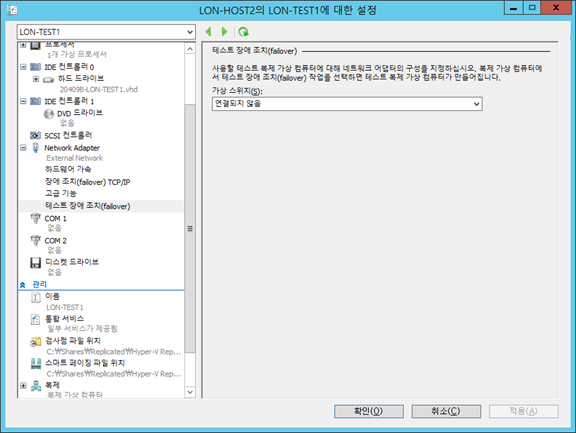

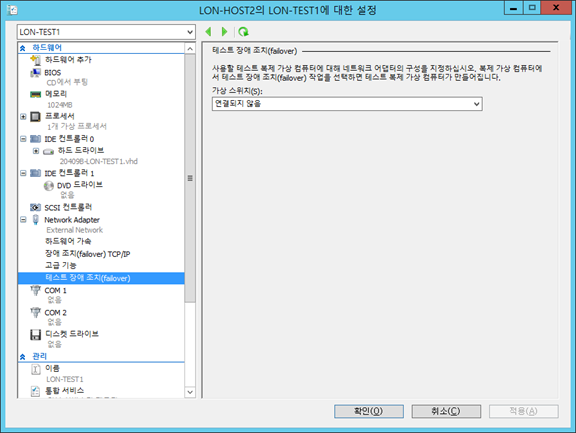

호스트2의 TEST1 속성을 보면 Test FailOver 에 대한 설정이 있음.

장애 조치에 위와 같은 값을 만듦.

테스트 장애 조치에는 별다른 옵션을 주지 않았음.

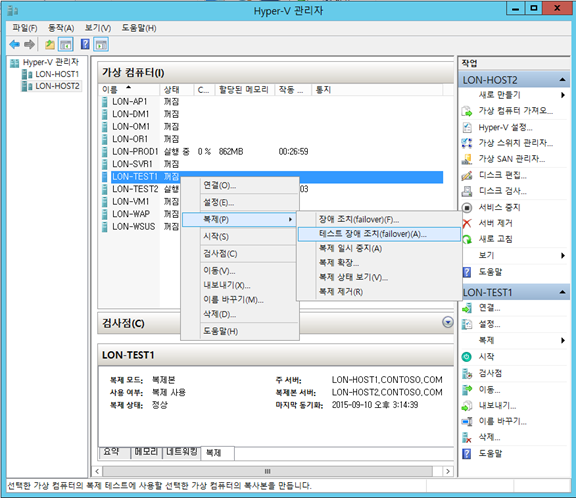

테스트 장애 조치를 클릭.

테스트 장애 조치 관련 VM이 새로 생기는 것을 볼 수 있음.

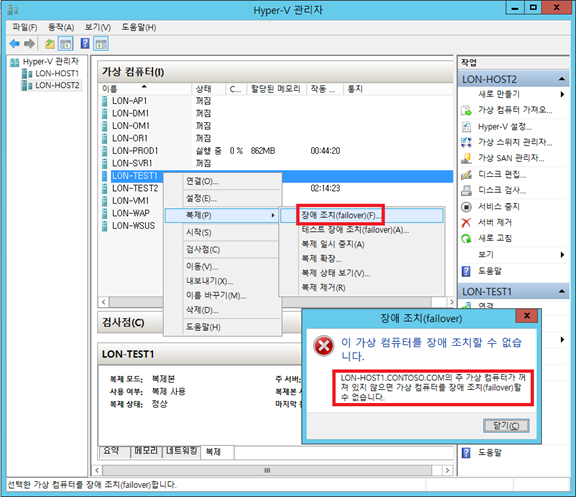

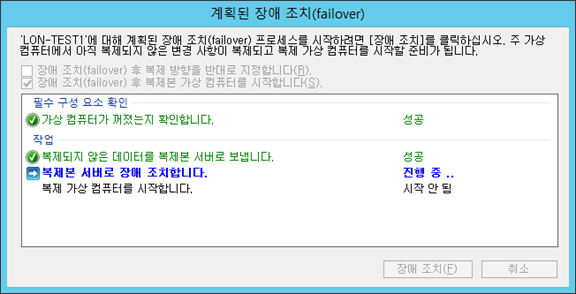

계획된 장애 조치

VM이 살아 있을 때에는 작동 안 됨.(Planned 이기 때문)

끄고 장애 조치를 하면 장애 조치가 완료됨.(검사점이 찍힌 것도 확인 가능)

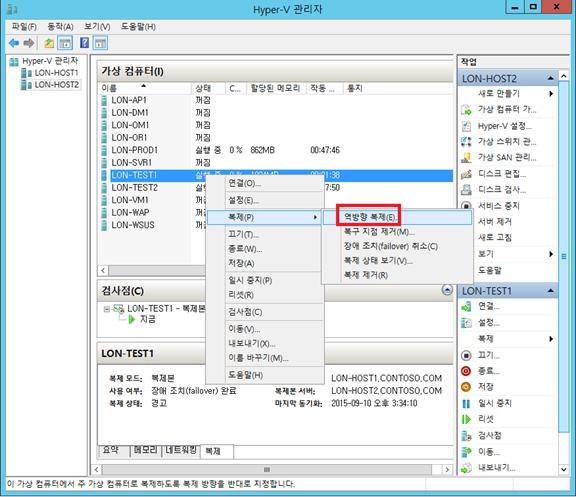

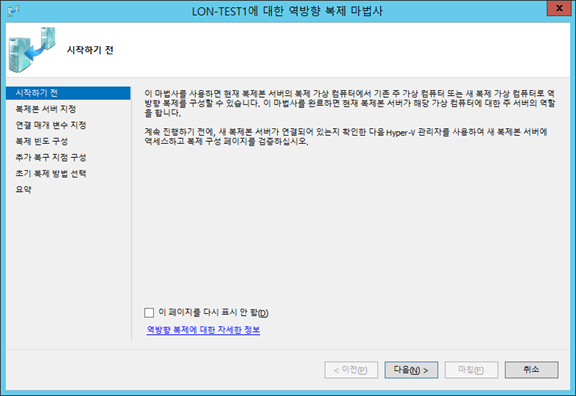

역방향 복제

복제본 보내는 중…

해당 VM을 끄고 계획된 장애 조치를 선택, 작업을 완료함

호스트 1,2의 TEST1에 대한 복제 제거

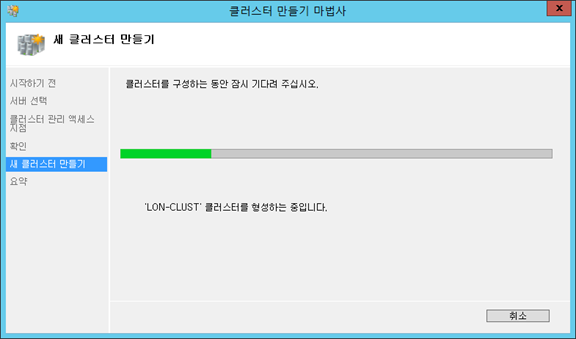

FAILOVER CLUSTER 만들기

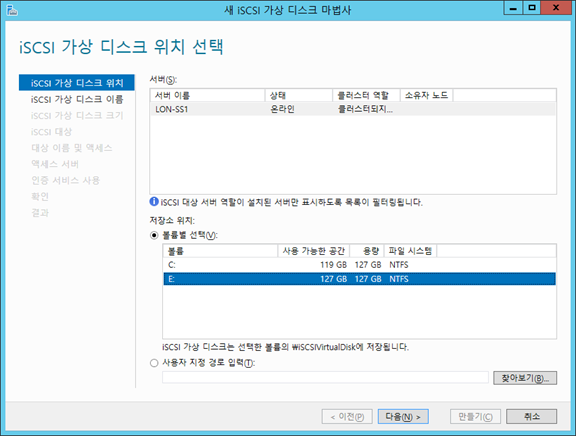

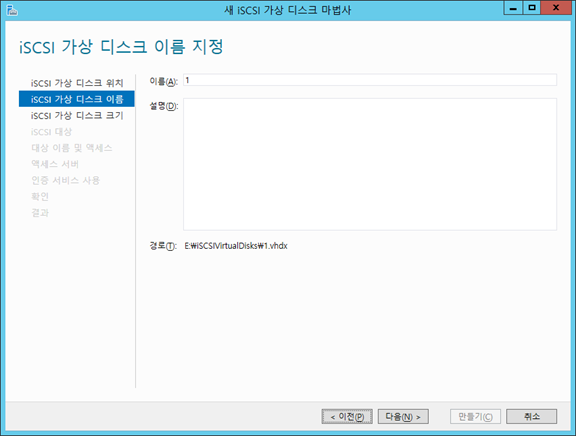

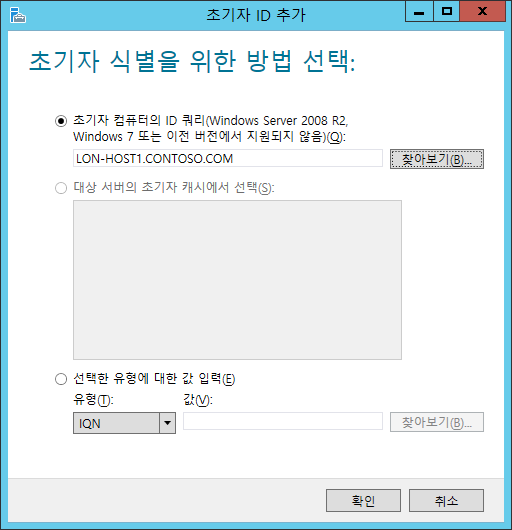

iSCSI Target에 붙을 수 있는 서버를 추가하는 것.

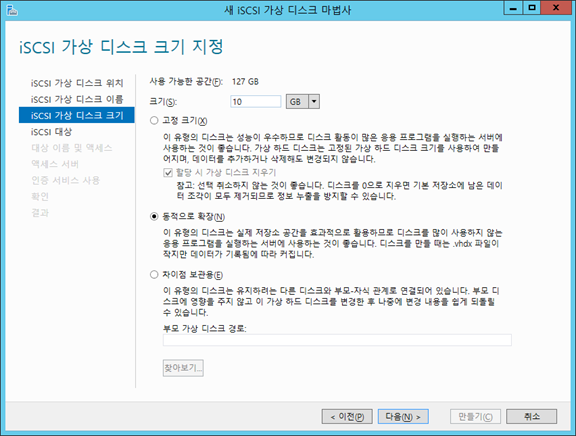

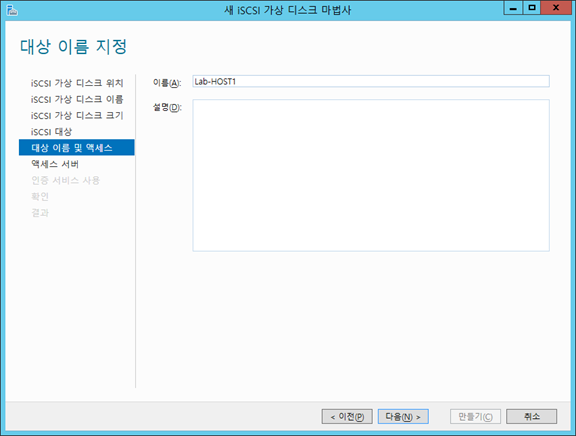

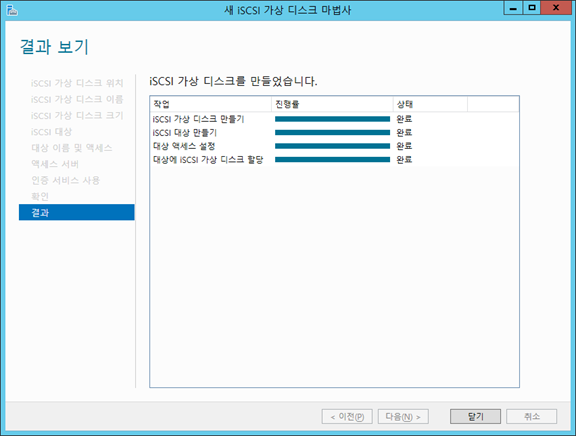

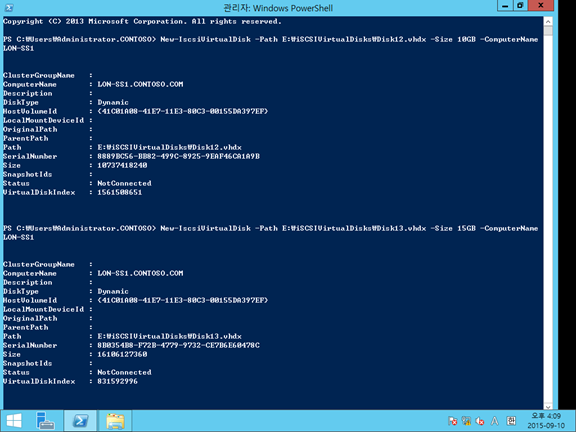

LON-SS1에 만듦.

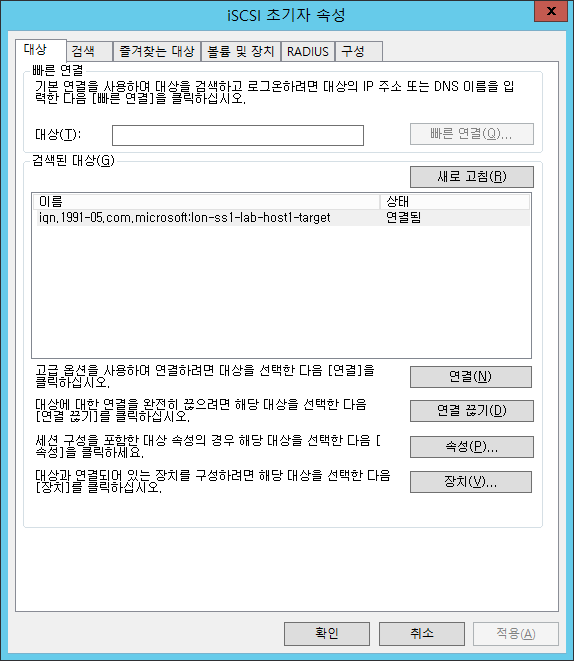

호스트2에 들어가서 iSCSI 초기자로 대상에 LON-SS1을 선택하여 새로고침하면 연결됨.

이런 식으로 붙음.

호스트 2. 잘 붙음.

호스트1에서도 ^^

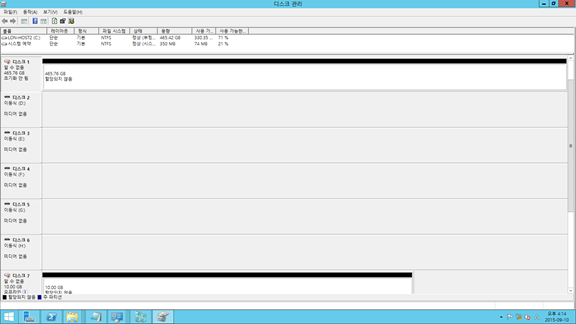

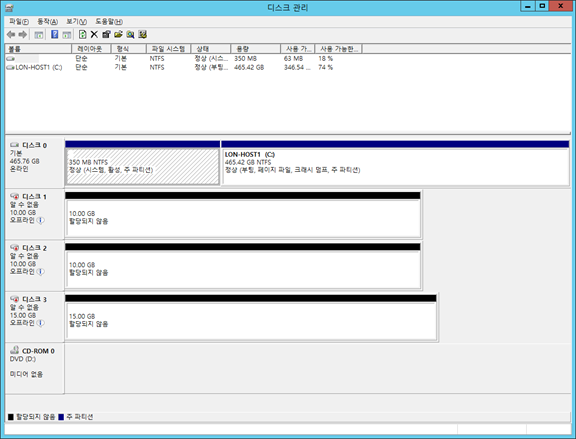

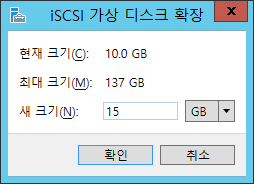

iSCSI 확장

5GB가 늘어남!

볼륨 확장을 하면 되겠죠?

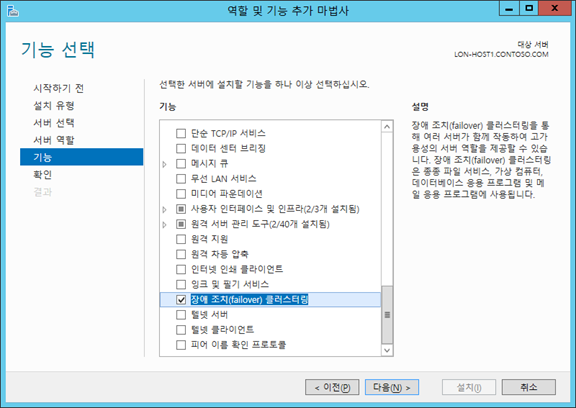

호스트 1,2에 FailOver Clustering 설치

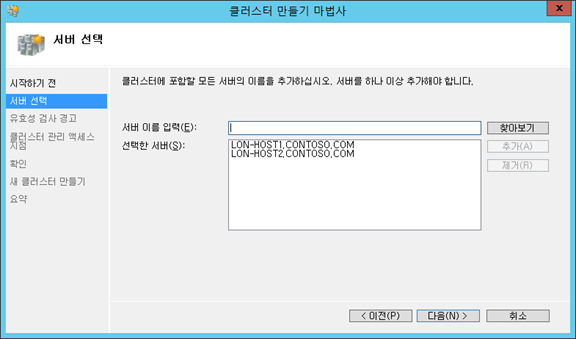

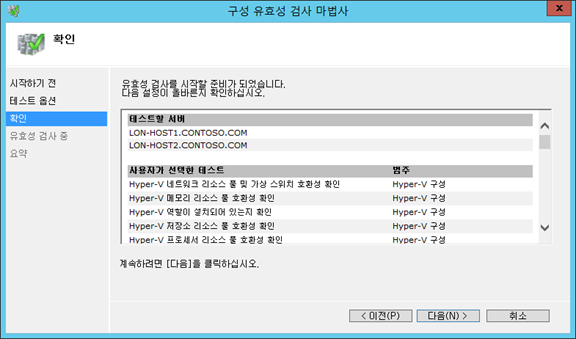

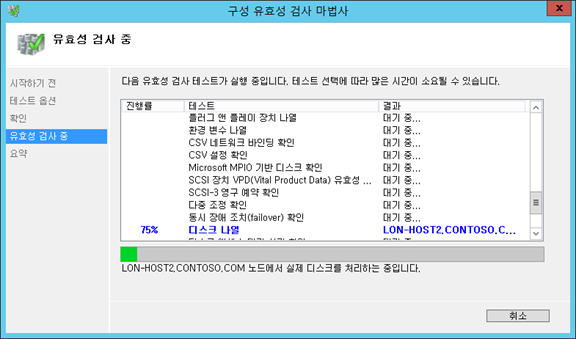

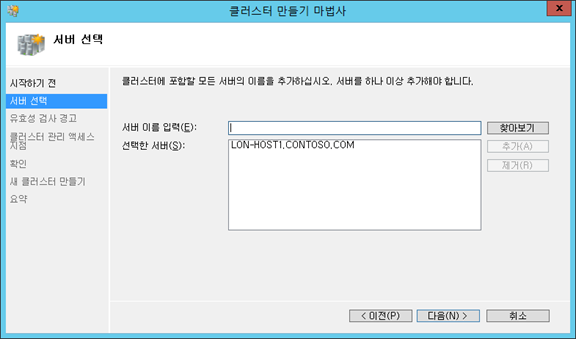

FAILOVER에 두 서버 추가

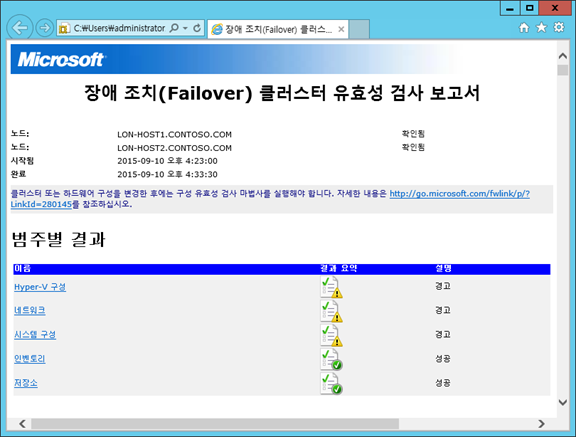

유효성 검사에 시간이 좀 걸림.

완료.

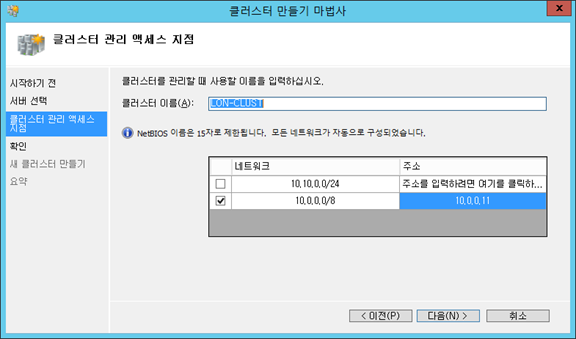

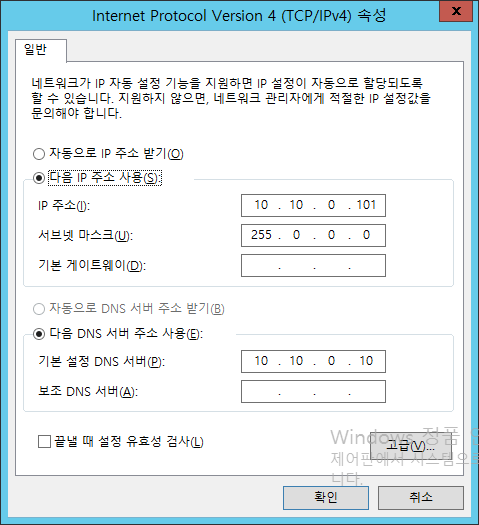

클러스터 생성 실패…

호스트 1,2를 모두 서브넷을 동일하게…

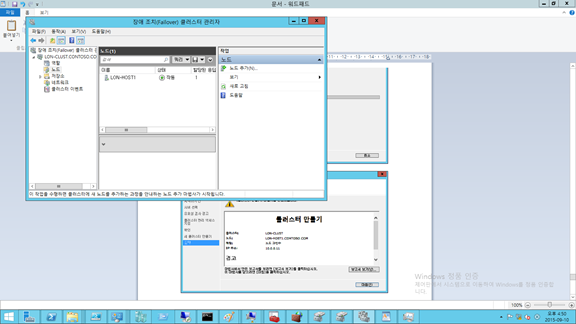

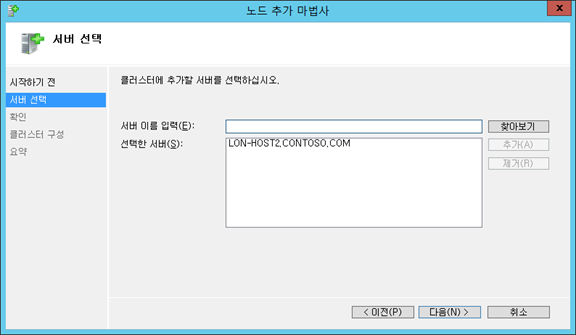

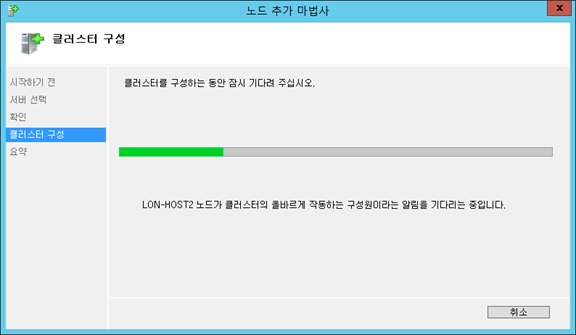

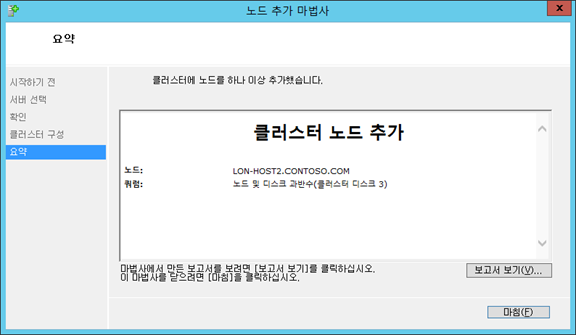

노드 추가!

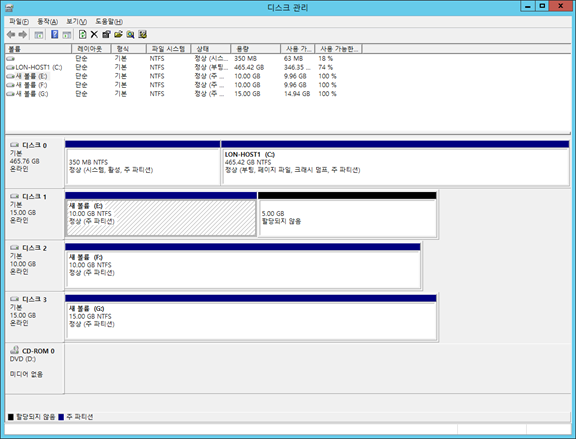

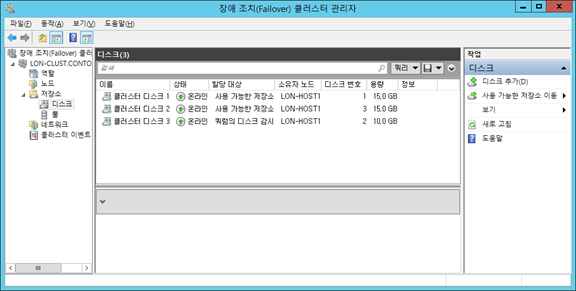

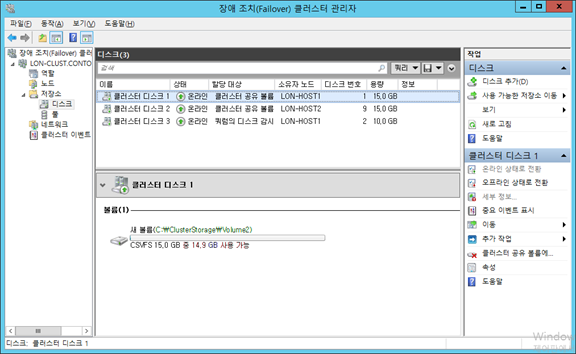

쿼럼이 아닌 디스크 2개를 잡고 클러스터 공유 볼륨에 추가

클러스터 공유 볼륨이 됨

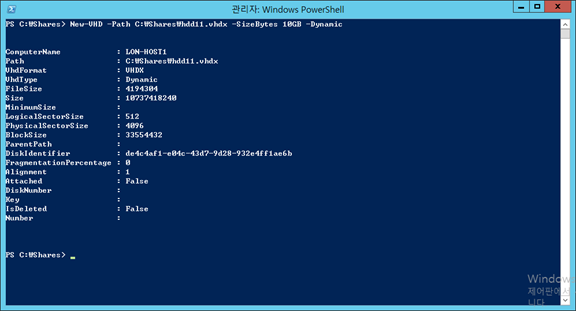

VHDX를 만들고…(동적)

ClusterStorage의 Volume1에 vhd02.vhdx 만들기

VM 하드 디스크로 VHD 파일들을 붙임

PROD2에 보면 VHDX가 붙은 것을 볼 수 있음.

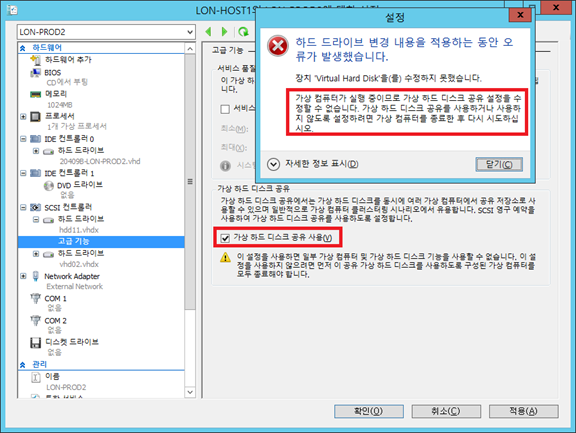

[가상 하드 디스크 공유 사용]

ClusterShared Volume이 아니라서 안 되고, (켜져 있어도 안 됨)

종료된 VM에 Cluster Share Volume에 있는 디스크 추가,

공유 사용 체크.

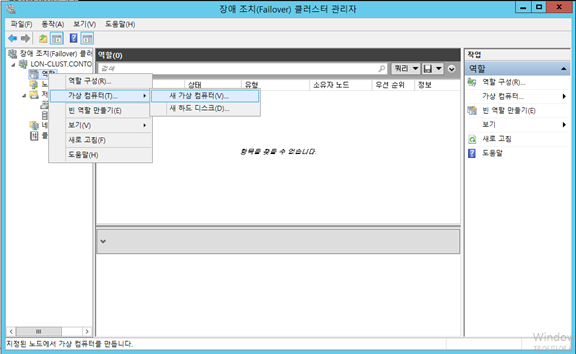

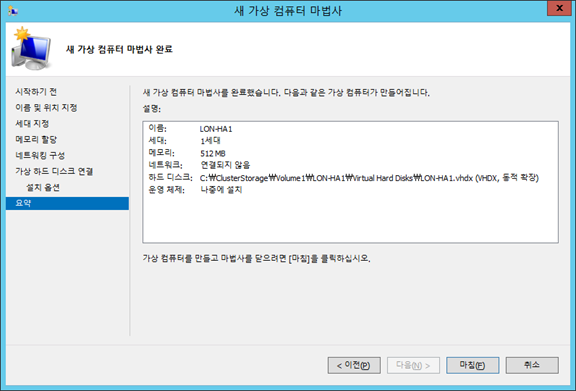

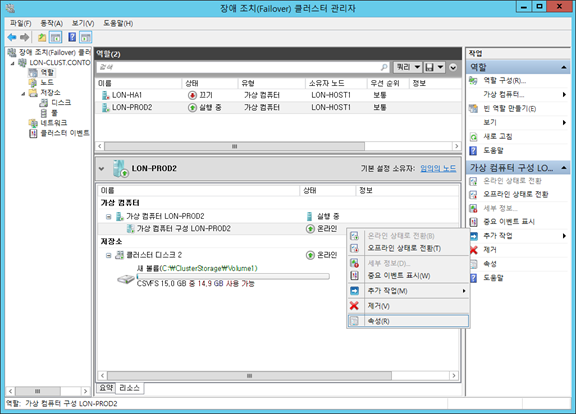

[Cluster에 VM만들기]

VM은 클러스터에 만들고 그 VM의 VHD 위치를 로컬로 하면 안되겠죠? CSV에 위치시킬 것.(만약 잘못 만들었다면 앞에서 했던 VHD 이동을 활용하면 됨)

테스트 목적이므로 기본값으로 진행

추가 완료!

Hyper-V 관리자에서도 추가됨.

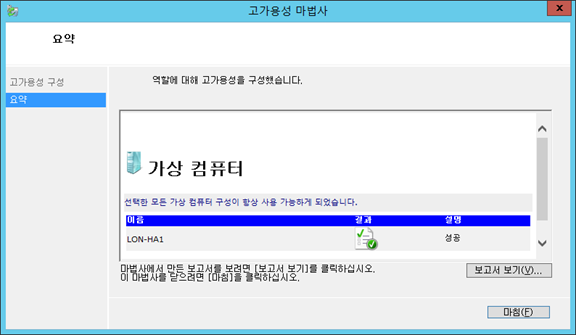

[기존 VM을 고가용성 VM으로 만들기]

이 커맨드를 통해 기존의 VM을 클러스터링 안으로 넣고, VHD 이동을 통해 Cluster Shared Volume에 옮기면 됨.

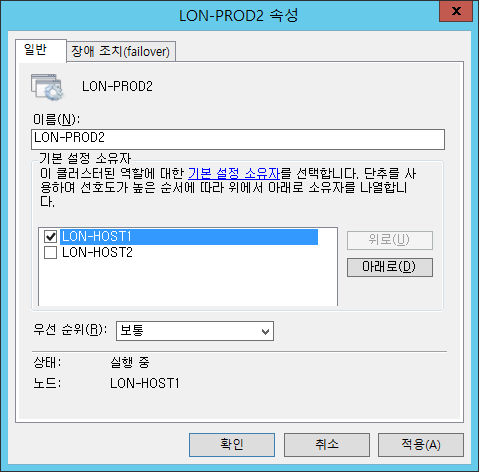

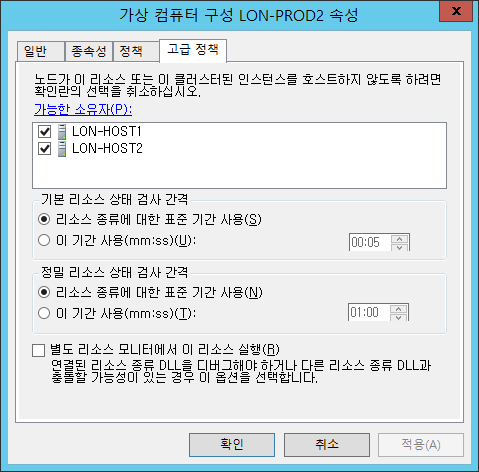

기본적으로 VM의 기본 설정 소유자는 지정되어 있지 않음.

여기서 설정된 순서대로 FailOver에서 해당 컴퓨터로 이동됨

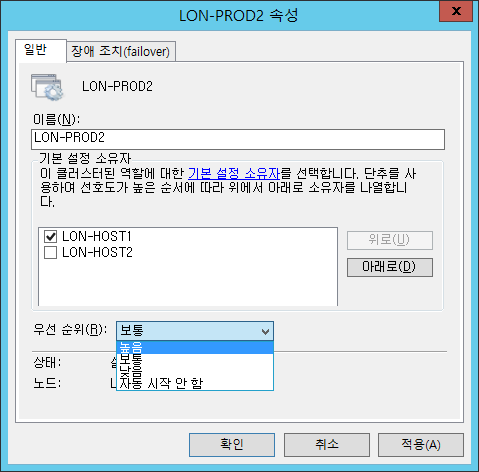

DC의 경우 가장 먼저 장애조치되어야 하므로 우선 순위를 ‘높음’으로 설정하면 됨

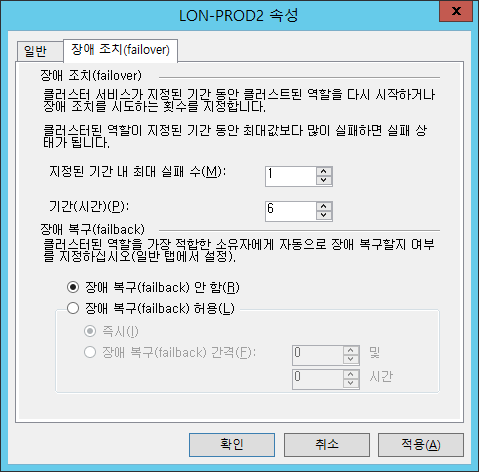

Failback에 대한 옵션도 존재.

구성에 대한 속성 보기 가능

위 호스트에서 제외하면 ??

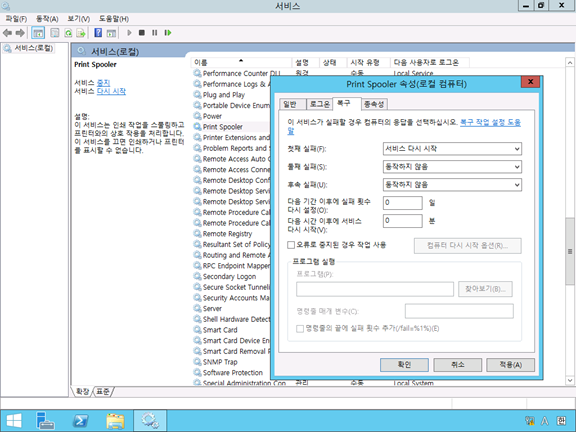

[앱 모니터링 기능]

서비스가 자동 재시작되지 않도록 설정한 후…

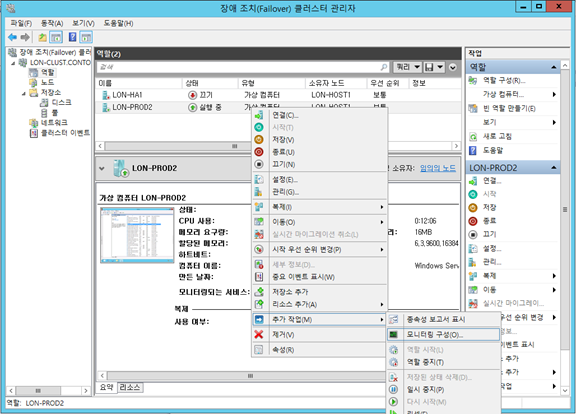

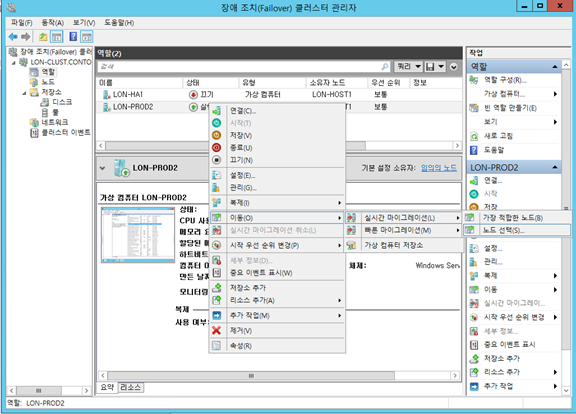

모니터링 구성에서

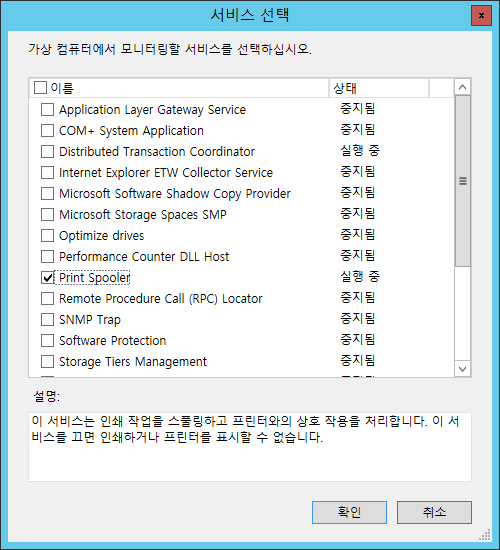

프린트 스풀러 서비스 선택

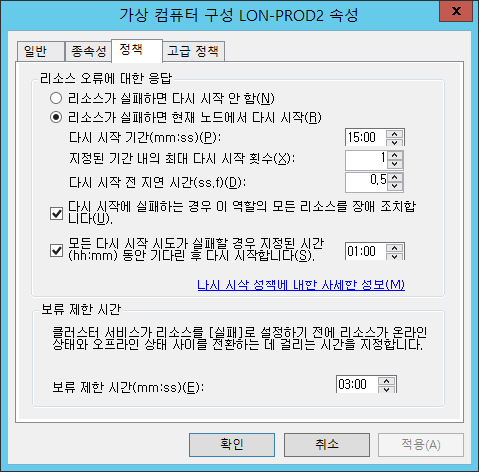

아까 봤던 리소스에 대한 속성에서 정책에 의해 Fail Over됨.

노드 선택